Commitments als temporale Entität – Warum der Betrag kein Feld, sondern ein Zeitintervall ist

In der Finanzindustrie werden Commitments traditionell als statische Datensätze mit einem Betrag und einem Datum modelliert. Diese Vereinfachung führt zu systematischen Problemen im Reporting, der Historisierung und der regulatorischen Dokumentation. Dieser Artikel analysiert, warum Commitments nicht als einzelne Zeile mit überschreibbaren Feldern, sondern als temporale Entität – eine Abfolge zeitlich definierter Zustände – zu verstehen sind und welche weitreichenden Konsequenzen dies für die Systemarchitektur hat.

Haftungsausschluss: Dieser Artikel dient ausschließlich Informationszwecken und stellt keine Anlageberatung, Rechtsberatung oder verbindliche Handlungsempfehlung dar. Die Ausführungen basieren auf meiner Erfahrung als unabhängiger Senior Business Consultant und Analyst.

Kernaussagen für Entscheider

- Das Kernproblem: Die traditionelle, statische Datenhaltung überschreibt historische Werte. Dies führt zwangsläufig zu fehlerhaften Reports, nicht reproduzierbaren Berechnungen und erheblichen Compliance-Risiken bei regulatorischen Prüfungen.

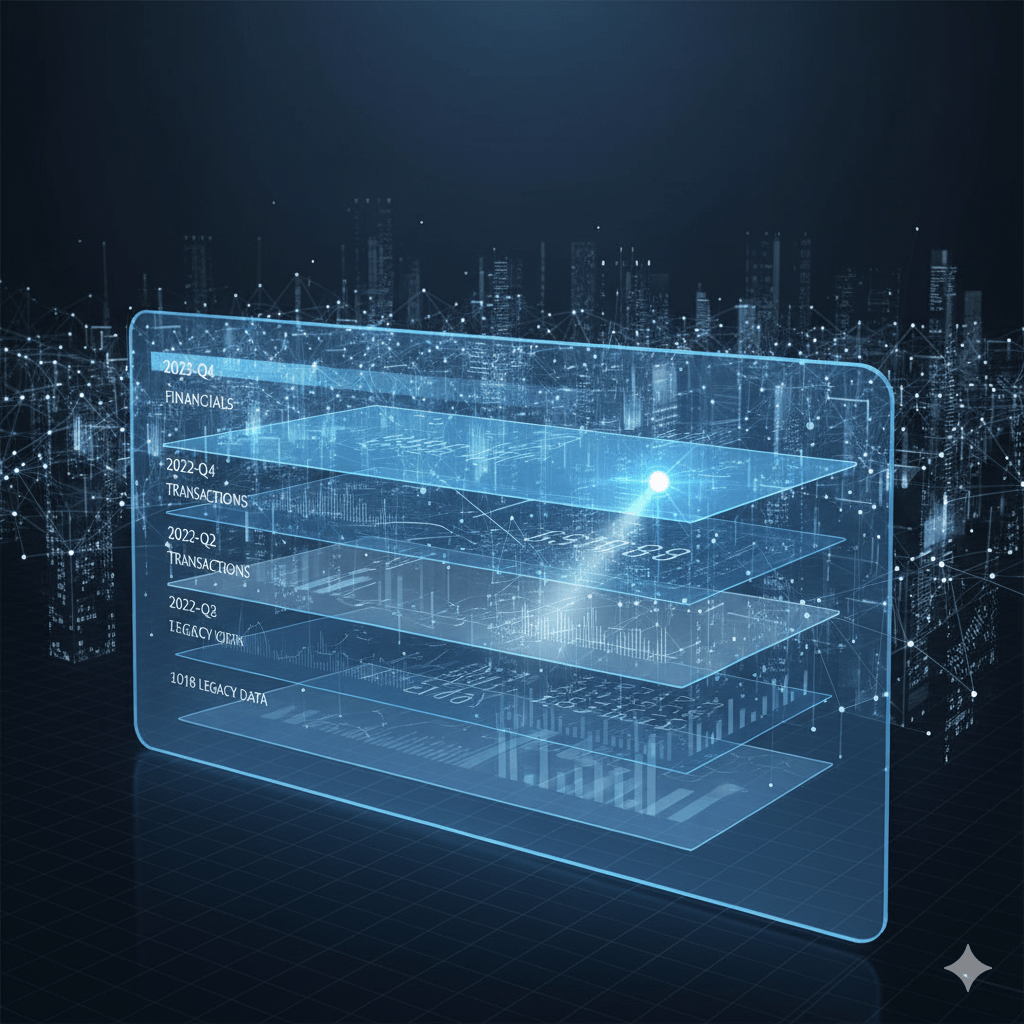

- Die konzeptionelle Lösung: Daten müssen als Zeitachse (temporale Entität) modelliert werden. Jede Änderung erzeugt einen neuen, historisch gültigen Zustand. Nur so lässt sich die Wahrheit zu jedem beliebigen Stichtag in der Vergangenheit exakt rekonstruieren.

- Die strategische Konsequenz: Moderne Datenarchitekturen wie Data Lakes oder Datenvirtualisierung sind ohne ein temporales Fundament in den Quellsystemen instabil. Sie virtualisieren Chaos und schaffen eine „Infinite Source of Confusion“ statt einer „Single Source of Truth“.

Hinweis zur Übertragbarkeit: Commitments dienen in diesem Artikel als exemplarischer Anwendungsfall. Die beschriebene Problematik der temporalen Datenhaltung gilt jedoch universell für alle Stammdaten, die sich über die Zeit verändern – von Investorendaten über Fondseigenschaften bis hin zu regulatorischen Klassifizierungen.

Das Commitment-Paradox: Wenn Stammdaten zu Bewegungsdaten werden

Die konventionelle Datenmodellierung behandelt Commitments als Stammdaten. Diese Struktur impliziert, dass ein Commitment zu einem bestimmten Zeitpunkt einen eindeutigen Betrag hat. In der operativen Realität durchlaufen Commitments jedoch eine Sequenz von Ereignissen:

- Initial Confirmation – Das ursprüngliche Commitment wird eingegangen

- Revised Amount – Der Betrag wird erhöht oder reduziert

- Transfer – Das Commitment wechselt den Inhaber

- Capital Call – Teile des Commitments werden abgerufen

- Distribution – Ausschüttungen können (in seltenen Fällen bei Recallable Capital) das verfügbare Commitment beeinflussen

Die Behandlung des Commitment-Betrags als überschreibbares Feld führt zum Verlust historischer Informationen. Wird beispielsweise ein initialer Betrag von 10 Mio. € später auf 12 Mio. € erhöht, überschreibt die konventionelle Architektur den ursprünglichen Wert. Für zeitpunktbezogene Berechnungen, etwa bei der Ermittlung der Commitment-Quote zu einem Stichtag in der Vergangenheit, ist diese Information jedoch unerlässlich.

Die Konsequenzen im Tagesgeschäft

Was theoretisch klingt, hat handfeste operative Auswirkungen:

- Regulatorisches Reporting: Aufsichtsbehörden fordern Snapshots zu historischen Stichtagen – ohne temporale Datenhaltung sind diese nicht reproduzierbar

- Investoren-Kommunikation: Quartalsberichte müssen nachvollziehbar sein, auch wenn sie Monate später erstellt werden

- Audit & Compliance: Wirtschaftsprüfer benötigen den Nachweis, dass Berechnungen zu einem historischen Zeitpunkt korrekt waren

- Performance Attribution: Die Analyse, wann und warum sich Commitments verändert haben, ist ohne Historie unmöglich

Temporale Entitäten: Das Konzept der Zeitintervalle

Eine temporale Entität ist ein Datenobjekt, dessen Eigenschaften nicht zu einem einzelnen Zeitpunkt, sondern über Zeitintervalle definiert sind. Jedes Intervall repräsentiert einen Gültigkeitszeitraum. Änderungen führen zur Erzeugung eines neuen Intervalls mit einem neuen Gültigkeitsbeginn.

Im Kontext von Commitments bedeutet dies: Der Betrag ist keine einzelne Zahl, sondern eine Funktion über der Zeit. Die Gesamtheit aller Intervalle bildet die vollständige, prüfbare Historie ab.

Vergleich: Statisch vs. Temporal

| Single-Row-Modellierung (Statisch) | Temporale Entität (Dynamisch) |

|---|---|

| Ein Datensatz pro Commitment | Multiple Datensätze mit Gültigkeitsintervallen |

| Betrag als überschreibbares Feld | Betrag als zeitabhängige Sequenz |

| Nur der aktuelle Status ist bekannt | Die gesamte Historie aller Statusänderungen ist verfügbar |

| Historische Abfragen sind unmöglich oder fehlerhaft | Zeitpunktbezogene Rekonstruktion ist jederzeit möglich |

Ein Zahlenbeispiel: Der verlorene Quartalsabschluss

Stellen Sie sich folgendes Szenario vor: Ein Investor gibt am 15. Januar ein Commitment über 10 Mio. €. Am 10. April wird dieses Commitment auf 12 Mio. € erhöht. Nun soll ein Report für den Quartalsabschluss zum 31. März erstellt werden.

Szenario 1: Die Single-Row-Modellierung (Der Fehler)

In einem statischen Modell wird der alte Wert einfach überschrieben. Die Datenbanktabelle sieht am 10. April so aus:

Commitment_ID | Investor_ID | Betrag | Letzte_Änderung

C-123 | INV-456 | 12.000.000 € | 2024-04-10Das Problem: Wenn Sie nun den Report für den 31. März erstellen, fragt das System den aktuellen Betrag ab und liefert 12 Mio. €. Dies ist faktisch falsch, da zu diesem Zeitpunkt das gültige Commitment 10 Mio. € betrug. Die historische Wahrheit ist verloren.

In der Praxis führt dies zu:

- Falschen Commitment-Quoten im Quartalsreport

- Nicht nachvollziehbaren Abweichungen gegenüber früheren Berichten

- Compliance-Verstößen bei regulatorischem Reporting

- Vertrauensverlust bei Investoren und Aufsichtsbehörden

Szenario 2: Die temporale Modellierung (Die Lösung)

In einem temporalen Modell wird kein Wert überschrieben. Stattdessen wird ein neues Intervall erzeugt. Die Datenbanktabelle (Commitment Update History) sieht am 10. April so aus:

Commitment_ID | Betrag | Gültig_Von | Gültig_Bis

C-123 | 10.000.000 € | 2024-01-15 | 2024-04-09

C-123 | 12.000.000 € | 2024-04-10 | (offen)Die Lösung: Für den Report zum 31. März sucht das System nun nach dem Intervall, in dem dieses Datum liegt. Die Abfragelogik lautet sinngemäß:

SELECT Betrag

WHERE Commitment_ID = 'C-123'

AND '2024-03-31' BETWEEN Gültig_Von AND COALESCE(Gültig_Bis, '9999-12-31')Das System findet die erste Zeile und liefert den korrekten historischen Wert von 10 Mio. €.

Zwei Seiten derselben Medaille: Event Sourcing vs. State-over-Time

Die temporale Datenhaltung kann technisch auf zwei fundamentalen Wegen umgesetzt werden. Das Verständnis beider Ansätze – und ihrer Beziehung zueinander – ist entscheidend für die Bewertung bestehender Systemlandschaften.

Event Sourcing: Die atomare Wahrheit

Beim Event Sourcing (auch Delta-Pflege genannt) wird nicht der Zustand selbst, sondern nur die Veränderung als unveränderlicher Datensatz gespeichert. Die Historie ist eine chronologische Kette von Ereignissen.

Beispiel:

Event_ID | Commitment_ID | Event_Type | Delta | Event_Date | Currency

E-001 | C-123 | Initial | +10.000.000| 2024-01-15 | EUR

E-002 | C-123 | Revised | +2.000.000 | 2024-04-10 | EUR

E-003 | C-123 | Capital_Call | -1.000.000 | 2024-05-20 | EURUm den Zustand zu einem Stichtag zu ermitteln (z.B. „Wie hoch war das Commitment am 31. März?“), muss das System alle Events bis zu diesem Datum aufsummieren.

Vorteile:

- ✓ Perfekter Audit Trail – jede Geschäftsaktion ist dokumentiert

- ✓ Mathematische Reinheit – es ist die „atomare“ Wahrheit

- ✓ Flexibilität – neue Analysen können durch „Replay“ der Events erstellt werden

- ✓ Kein Datenverlust – auch nachträgliche Korrekturen sind sichtbar

Nachteile:

- ✗ Abfragekomplexität – Summenbildung bei jeder Abfrage notwendig

- ✗ Performance – bei langen Historien rechenintensiv

- ✗ Fachliche Komplexität – Berechnungslogik muss extern implementiert werden

State-over-Time: Die abfrageoptimierte Projektion

Beim State-over-Time-Ansatz wird der resultierende Zustand für jedes Zeitintervall explizit gespeichert. Jedes Ereignis schließt das alte Intervall und eröffnet ein neues mit dem aktualisierten Zustand.

Beispiel:

Commitment_ID | Betrag | Gültig_Von | Gültig_Bis | Grund

C-123 | 10.000.000 €| 2024-01-15 | 2024-04-09 | Initial Confirmation

C-123 | 12.000.000 €| 2024-04-10 | (offen) | Revised AmountVorteile:

- ✓ Extrem schnelle Abfragen – simple BETWEEN-Logik

- ✓ Intuitive Lesbarkeit – der Zustand ist direkt sichtbar

- ✓ Reporting-Performance – ideal für Business Intelligence

Nachteile:

- ✗ Datenredundanz – Zustände werden wiederholt gespeichert

- ✗ Komplexität bei der Erstellung – Intervall-Logik muss korrekt sein

- ✗ Weniger granular – zwischen zwei Intervallen ist nichts sichtbar

Die Synthese: CQRS-Architektur

In der Praxis sind dies keine Gegensätze, sondern zwei Seiten derselben Medaille. Eine moderne, robuste Architektur verwendet oft beide Konzepte in einer sogenannten CQRS-Architektur (Command Query Responsibility Segregation):

- Die „Write Side“: Alle Änderungen werden als Events in einem unveränderlichen Log gespeichert (Event Sourcing). Dies ist die ultimative Single Source of Truth.

- Die „Read Side“: Ein separater Prozess liest diese Events und „projiziert“ sie in ein für Abfragen optimiertes Modell – zum Beispiel in eine Tabelle mit temporalen Intervallen (State-over-Time).

Praktische Konsequenz: Die Events sind die Quelle der Wahrheit, aus der für schnelle Abfragen die State-over-Time-Sicht generiert wird. Beide Ebenen sind notwendig, aber für unterschiedliche Zwecke.

Konsequenzen für die Systemlandschaft: IBOR, Data Lakes und die Frage der Vollständigkeit

Die Umstellung auf ein temporales Modell hat tiefgreifende Auswirkungen auf die IT-Architektur. Viele Asset Manager verfügen über etablierte IBOR-Systeme (Investment Book of Record), die seit Jahren Delta-Buchungen unterstützen. Stellt sich die Frage: Reicht das aus?

Das IBOR-Delta-Paradox: Warum Ereignisse allein nicht genügen

Moderne IBOR-Systeme speichern transaktionale Historie – jede Änderung wird als Buchung erfasst. Auf den ersten Blick scheint dies perfektes Event Sourcing zu sein. Die operative Realität zeigt jedoch drei kritische Lücken:

1. Die gekapselte Berechnungslogik

IBOR-Systeme speichern zwar Events, aber die Logik zur Zustandsberechnung ist proprietär und oft nicht dokumentiert:

- Wie wird das „Unfunded Commitment“ nach einer Multi-Currency Capital Call berechnet?

- Welcher FX-Kurs wird verwendet – Trade Date oder Settlement Date?

- Wie werden Rundungsdifferenzen behandelt?

Das Problem: Downstream-Systeme (Reporting, Data Warehouse, Analytics) haben keinen Zugriff auf diese Logik. Sie müssen entweder die Events selbst interpretieren (Risiko von Inkonsistenzen) oder die bereits berechneten Ergebnisse verwenden (Verlust der Granularität).

2. Der fehlende Business-Kontext

Ein Event im IBOR lautet beispielsweise:

Transaction_Type: COMMITMENT_REVISION | Delta: +2M EUR | Date: 2024-04-10Was fehlt: Der fachliche Kontext – warum wurde das Commitment erhöht?

- War es eine freiwillige Aufstockung des Investors?

- Eine vertragliche Anpassung aufgrund einer Fondsverlängerung?

- Eine regulatorische Korrektur aufgrund eines früheren Fehlers?

Für Compliance und Audit ist dieser Kontext entscheidend, aber er ist in reinen Delta-Buchungen nicht enthalten.

3. Die Multi-Currency-Komplexität

Bei internationalen Fonds gibt es Commitments in verschiedenen Währungen. Ein typisches Event:

Capital Call: -1M USD | Event_Date: 2024-05-20 | FX_Rate: 1.0850 EUR/USDDie Herausforderungen:

- Wird der EUR-Wert zum Zeitpunkt der Transaktion „eingefroren“ oder bei FX-Änderungen neu bewertet?

- Wie wird das aggregierte Commitment auf Fondsebene berechnet, wenn Investoren in verschiedenen Währungen committet haben?

- Welche FX-Quelle ist maßgeblich, und ist diese Historie selbst temporal verfügbar?

Ohne zentrale, dokumentierte Logik führt dies zu „Multiple Versions of Truth“ – jedes System berechnet unterschiedliche Werte.

Der pragmatische, aber gefährliche Weg: Snapshots im Data Lake

Viele Organisationen verfolgen daher einen pragmatischen Ansatz:

- Das IBOR-System berechnet Zustände zu bestimmten Stichtagen (z.B. Monatsende)

- Diese „Snapshots“ werden in einen Data Lake oder ein Data Warehouse geladen

- Reporting und Analytics arbeiten mit diesen Snapshots

Die Risiken dieses Ansatzes:

| Problem | Konsequenz |

|---|---|

| Granularitätsverlust | Änderungen zwischen den Stichtagen sind nicht sichtbar |

| Black Box | Die Berechnungslogik ist nicht nachvollziehbar |

| Keine Reproduzierbarkeit | Historische Berechnungen können nicht validiert werden |

| Datenvirtualisierung scheitert | On-the-fly-Berechnungen liefern inkonsistente Ergebnisse |

Die Gefahr der Datenvirtualisierung: Wenn die zugrundeliegenden Quellsysteme keine temporale Integrität besitzen und historische Zustände überschreiben, dann virtualisiert man lediglich inkonsistente und nicht reproduzierbare Daten. Das Ergebnis ist eine trügerische Echtzeit-Sicht auf einem brüchigen Fundament.

Die Lösung: Temporale APIs statt Snapshots

Die tragfähige Architektur erfordert, dass das IBOR nicht nur Snapshots, sondern temporale APIs bereitstellt:

GET /commitments/C-123/state?as_of=2024-03-31

Response:

{

"commitment_id": "C-123",

"amount": 10000000,

"currency": "EUR",

"unfunded": 10000000,

"valid_from": "2024-01-15",

"valid_until": "2024-04-09",

"calculation_method": "sum_of_deltas",

"fx_rates_used": {...}

}Die kritischen Eigenschaften:

- ✓ Der Zustand zu jedem historischen Zeitpunkt ist abfragbar

- ✓ Die Berechnungslogik ist dokumentiert und zentral

- ✓ FX-Kurse und Annahmen sind explizit

- ✓ Die Single Source of Logic ist gewahrt

Was fehlt noch? Die blinden Flecken des Modells

Selbst ein perfektes temporales Modell für finanzielle Transaktionen ist noch nicht vollständig. Zwei entscheidende Aspekte werden in der Praxis oft übersehen:

1. Nicht-finanzielle temporale Daten

Commitments existieren nicht isoliert. Sie sind mit Metadaten verknüpft, die sich ebenfalls über die Zeit verändern:

Beispiele:

- Investoren-Klassifizierung: Ein Investor wechselt von „Professional“ zu „Institutional“ – dies beeinflusst regulatorisches Reporting

- Rechtlicher Status: Änderung des Steuerdomizils oder der Rechtsform

- Berechtigungen: Ein Investor erhält nachträglich Side Letter-Rechte (z.B. Co-Investment-Optionen)

- Risikoeinstufung: Änderung der AML/KYC-Klassifizierung aufgrund neuer Informationen

Die Herausforderung: Diese Daten werden oft in separaten Systemen gepflegt (CRM, Legal Entity Management, Compliance-Systeme) und sind nicht temporal synchronisiert. Ein Report zum 31. März muss aber die damals gültigen Klassifizierungen verwenden, nicht die heutigen.

2. Die semantische Ebene: Business-Events statt technischer Transaktionen

Rohe Delta-Events sind technisch korrekt, aber fachlich stumm. Ein vollständiges Modell benötigt eine Ontologie – eine strukturierte Beschreibung des Geschäftskontexts:

| Technisches Event | Semantische Anreicherung |

|---|---|

COMMITMENT_REVISION: +2M EUR | Grund: „Voluntary Top-Up“ / Vertrag: „Side Letter #3“ / Genehmigt von: „IC Decision 2024-04“ |

CAPITAL_CALL: -1M USD | Investment: „Deal-XYZ“ / Call-Nummer: 3/12 / Fälligkeit: 2024-06-15 |

COMMITMENT_TRANSFER: INV-A → INV-B | Rechtsgrund: „Estate Planning“ / Dokument: „Transfer Agreement 2024-05“ |

Warum ist dies kritisch?

- Compliance: Regulatoren fragen nicht nach Deltas, sondern nach Geschäftsvorfällen

- Audit: Wirtschaftsprüfer müssen den Zusammenhang zwischen Commitment-Änderung und Fondsdokumentation nachvollziehen können

- Analytics: „Warum haben wir letztes Jahr 30% mehr Commitment-Erhöhungen als dieses Jahr?“ ist nur beantwortbar, wenn die Gründe strukturiert vorliegen

Die versteckte Komplexität: FX-Neubewertung und smarte Zwischenspeicher

Eine oft unterschätzte Herausforderung bei der temporalen Datenhaltung entsteht bei Fremdwährungs-Commitments. Das Problem: Für jeden historischen Stichtag muss das Unfunded Commitment in der Fondswährung neu berechnet werden – und das erfordert eine iterative Schleife durch alle historischen Events.

Das iterative Problem: Warum eine einfache Abfrage nicht ausreicht

Nehmen wir ein konkretes Beispiel:

Commitment C-456:

- Initial: 10M USD (15.01.2020)

- Revised: +2M USD (10.04.2021)

- Capital Call: -3M USD (20.05.2022)

- Capital Call: -2M USD (15.03.2023)

Aufgabe: Berechne das Unfunded Commitment in EUR für jeden Monatsletzten der letzten 5 Jahre.

Die Herausforderung:

- 5 Jahre × 12 Monate = 60 Stichtage

- Für jeden Stichtag: Alle Events bis zu diesem Datum durchlaufen

- Jedes Event mit dem FX-Kurs des Event-Datums in EUR umrechnen

- Akkumulieren: Initial + Revisions – Capital Calls

- Bei 500 Investments und 10+ Jahren Historie: Potenziell Millionen Berechnungen

Die naive Lösung – und warum sie scheitert

Variante A: „Alles täglich speichern“

- 500 Investments × 3.650 Tage = 1,8 Millionen Datensätze

- Problem: Datenexplosion, Speicherkosten, Wartungskomplexität

Variante B: „Alles bei Abfrage berechnen“

- Jede Abfrage durchläuft alle Events seit Inception

- Problem: Inakzeptable Performance bei Reports über längere Zeiträume

- Beispiel: Ein Jahresbericht mit monatlichen Werten für 500 Commitments benötigt 12 × 500 × Ø 20 Events = 120.000 Einzelberechnungen

Die pragmatische Architektur: Source berechnet, Target speichert

Die tragfähige Lösung basiert auf einer klaren architektonischen Trennung:

1. Source of Truth (IBOR-System):

- Speichert nur die unveränderlichen Events

- Speichert FX-Rates täglich aus zuverlässiger Quelle

- Berechnet Zustände immer frisch on-demand

- Stellt Berechnungslogik über APIs bereit

2. Target (Data Lake / Data Warehouse):

- Speichert materialisierte Snapshots zu strategischen Stichtagen (Monatsende, Quartalsende)

- Diese Snapshots sind read-optimiert und enthalten bereits das EUR-Equivalent

- Wichtig: Target schreibt nie zurück zum Source (Einbahnstraße)

3. Smarte Zwischenspeicher (unsichtbar für Nutzer):

- Cache-Ebene zwischen Source und Target

- Hält häufig abgefragte Berechnungen temporär vor

- Wird automatisch invalidiert bei strukturellen Änderungen (z.B. nachträgliche Korrekturen)

Incremental Refresh: Nicht alles, nur das Nötige

Der entscheidende Performance-Trick liegt im Incremental Refresh. Statt für jeden Report die komplette Historie neu zu berechnen, nutzt das System das letzte materielle Event als Marker:

Beispiel:

Commitment C-456:

- Letzter Snapshot: 31.03.2024 (Unfunded: 7M USD = 6.41M EUR bei FX 1.092)

- Letzte materielle Änderung: Capital Call am 20.05.2024 (-1M USD)

- Heute: 15.11.2024

Abfrage: "Unfunded per 31.10.2024?"

→ System startet bei Snapshot 31.03.2024

→ Berechnet nur Events zwischen 01.04. - 31.10.2024 (in diesem Fall: ein Capital Call)

→ Ergebnis: 6.41M EUR - (1M USD × FX 20.05.) = 5.32M EUROhne Incremental Refresh: System müsste alle Events seit 2020 durchlaufen (>50 Events)

Mit Incremental Refresh: System berechnet nur 1 Event ab letztem Snapshot

Die Invalidierungs-Strategie: Was passiert bei Korrekturen?

Die größte Gefahr für Zwischenspeicher sind nachträgliche Korrekturen. Beispiel: Ein Capital Call vom März 2023 wird im November 2024 korrigiert (falscher Betrag).

Konsequenz:

- Alle Snapshots ab März 2023 sind potenziell falsch

- Der Zwischenspeicher muss selektiv invalidiert werden

- Nur die betroffenen Commitments werden neu berechnet, nicht alle 500

Best Practice:

- Events werden nie gelöscht, sondern durch Reversal-Events korrigiert

- Jedes Reversal-Event triggert automatisch eine Neuberechnung aller nachfolgenden Snapshots

- Die ursprünglichen (falschen) Snapshots bleiben für Audit-Zwecke erhalten, werden aber als „superseded“ markiert

Praktische Konsequenz: Die Balance zwischen Performance (Snapshots) und Flexibilität (on-demand Berechnung) ist der Schlüssel. Viele IBOR-Systeme nutzen monatliche Snapshots kombiniert mit Incremental Refresh für Intra-Month-Abfragen. Die Zwischenkalkulationen bleiben dabei für Nutzer vollständig transparent – sie sehen nur das validierte Endergebnis.

Der Migrationspfad: Von der alten in die neue Welt

Die Umstellung einer bestehenden, statischen Datenhaltung auf ein temporales Modell ist ein komplexes Migrationsprojekt. Der Schlüssel zum Erfolg liegt darin, die historische Wahrheit zu rekonstruieren und in einer Phase des Parallelbetriebs zu validieren.

Die kritischen Schritte:

- Rekonstruktion: Historie aus Transaktionslogs, archivierten Berichten und Legacy-Systemen zusammensetzen

- Validierung: Historische Reports müssen mit der neuen Architektur exakt reproduzierbar sein

- Cutover: Umstellung zu einem Periodenende mit definierter Rollback-Strategie

Herausforderung: Audit-Logs reichen oft nur 7 Jahre zurück. Für ältere Fonds muss die Historie aus dokumentbasierten Quellen (PDFs, Excel, E-Mails) rekonstruiert werden – eine aufwändige, aber unerlässliche Aufgabe.

Universelle Gültigkeit: Über Commitments hinaus

Obwohl dieser Artikel Commitments als Beispiel verwendet, gilt die Problematik der temporalen Datenhaltung universell für alle sich verändernden Stammdaten:

Weitere betroffene Entitäten im Asset Management

- Investoren-Stammdaten: Rechtsform, Steuerdomizil, Klassifizierung (Institutional/Retail)

- Fondseigenschaften: Management Fee, Hurdle Rate, Catch-Up-Mechanismus

- Bewertungen: NAV, GAV, Wertansätze einzelner Assets

- Regulatorische Klassifizierungen: AIFMD-Status, MiFID-Kategorien, ESG-Ratings

- Kontrahenten: Bank Accounts, Custodians, Transfer Agents

- Rechtliche Dokumente: LPA-Versionen, Side Letters, Investorenzustimmungen

Das gemeinsame Muster: All diese Entitäten ändern sich im Zeitverlauf, und für jedes regulatorische oder operative Reporting muss der zum Stichtag gültige Zustand rekonstruierbar sein.

Die Datenvirtualisierung als Lackmustest

Der aktuelle Trend zur Datenvirtualisierung (virtuelle Data Layer, die Daten aus Quellsystemen „on the fly“ aggregieren) macht temporale Integrität zur Überlebensfrage:

- Wenn die Quellsysteme keine temporale Konsistenz haben, virtaualisiert man Chaos

- Jede Abfrage liefert potenziell andere Werte, je nachdem, wann sie ausgeführt wird

- Die versprochene „Single Source of Truth“ wird zur „Infinite Source of Confusion“

Die Schlussfolgerung: Temporale Strukturen sind nicht optional – sie sind die unabdingbare Voraussetzung, um die Versprechen moderner Architekturen (Data Mesh, Data Fabric, Virtualisierung) im anspruchsvollen Private Markets-Umfeld überhaupt sicher einlösen zu können.

Fazit: Eine konzeptionelle Notwendigkeit, keine technische Spielerei

Die Modellierung von Commitments als temporale Entität ist keine akademische Übung, sondern eine konzeptionelle Notwendigkeit für jede Organisation, die:

- Regulatorisches Reporting durchführt

- Audit-Anforderungen erfüllen muss

- Historische Performance analysiert

- Investoren-Kommunikation nachvollziehbar gestalten will

- Moderne Datenarchitekturen (Virtualisierung, Data Mesh) einsetzen möchte

Die kritischen Erfolgsfaktoren

- Event Sourcing als Fundament: Alle Änderungen als unveränderliche Events speichern

- State-over-Time für Performance: Projizierte Intervalle für schnelle Abfragen

- Zentrale Berechnungslogik: Single Source of Logic über APIs bereitgestellt

- Semantische Anreicherung: Business-Kontext zu den Events mitführen

- Nicht-finanzielle Temporalität: Auch Metadaten temporal modellieren

- Multi-Currency-Transparenz: FX-Kurs und Revaluation-Logik dokumentieren

Die Investition lohnt sich

Die Umstellung erfordert initiale Investitionen in Architektur, Migration und Change Management. Sie schafft jedoch die einzig belastbare Grundlage für:

- Reproduzierbare, auditierbare Berichte

- Skalierbare Datenarchitekturen

- Vertrauen bei Investoren und Aufsichtsbehörden

- Rechtssicherheit bei regulatorischen Prüfungen

- Zukunftsfähige Systemlandschaften

In einer Branche, in der Vertrauen auf Nachvollziehbarkeit basiert, ist temporale Integrität kein Nice-to-Have – sie ist Table Stakes.

Quellen

Ich bin unabhängiger Senior Business Consultant und Analyst mit Fokus auf Private Market Investments. Dieser Artikel basiert auf meinen Erfahrungen und gibt ausschließlich meine persönliche fachliche Einschätzung wieder.